Siri, Alexa, OK Google o Cortana aprenden de nosotros. ¿Con qué sesgos los estamos alimentando?

Aunque en América Latina el uso de asistentes personales hogareños como Alexa o Google Home sea todavía escaso, la presencia de los asistentes inteligentes en dispositivos como nuestros teléfonos es una realidad cotidiana. Siri en los iPhones y Google Assistant en los Android nos ayudan a resolver dudas o a elegir el camino más eficiente a casa. ¿De dónde sacan la información?, ¿cuáles son los criterios por los que eligen una fuente por sobre otra?, ¿quién diseña las respuestas predeterminadas? Estas preguntas nos ayudarán a llegar al meollo de la cuestión.

En su artículo Cómo los asistentes digitales virtuales como Alexa amplifican el sexismo, la periodista Morgan Meaker se hace estas preguntas y nos ofrece algunas respuestas. El primer sesgo machista con el que nos topamos es que todos los asistentes tienen voz de mujer. La asistencia, así como las tareas de cuidados, son roles feminizados y la voz femenina se asocia a características como la amabilidad, la comprensión, . En 2018 la Confederación Nacional de Mujeres e Igualdad y la Asociación de Hombres por la Igualdad de Género, junto con la agencia Tango, lanzaron en España una campaña para cuestionar por qué los asistentes personales virtuales tienen voz de mujer. El resultado fue una serie de afiches con órdenes dirigidas a las principales asistentes virtuales. «Los asistentes virtuales a los que les decimos qué tienen que hacer exactamente tienen voz femenina», se puede leer entre líneas.

Este aspecto fue ampliamente cuestionado y hoy por hoy la mayoría de los asistentes tienen varias voces para elegir. Incluso existen ahora iniciativas como Q, cuya voz está desarrollada a partir de la mezcla de voces de cinco personas no binarias.

Pero los sesgos machistas van mucho más allá. Los asistentes aprenden a partir de la información a la que acceden en Internet, ya sean blogs, Wikipedia u otras páginas web. Si esta información está sesgada los resultados de ese aprendizaje también lo serán. Y eso es lo que ocurre: los estereotipos se reproducen. Por ejemplo, Wikipedia, una de las fuentes fundamentales de los asistentes, contiene artículos redactados en su mayoría por hombres occidentales. Si la fuente de los asistentes tiene sesgos de género, sus resultados también lo tendrán.

Pero los sesgos no se encuentran exclusivamente en los contenidos, lo algoritmos también pueden ser machistas. Un caso que ilustra esto perfectamente es el del traductor de Google que reproducía los sesgos de las profesiones masculinizadas y feminizadas. Es decir, si traducíamos desde un idioma neutro en términos de género como el turco al inglés, el resultado era «él es un médico» y «ella es una enfermera», aún cuando el idioma de origen no indicara el género de la persona. Las quejas fueron tales que el equipo de Google se puso a trabajar en ello y ahora ofrece las dos posibilidades.

Casos como este exceden a los asistentes virtuales personales. Recordarán el sistema automatización de la selección de personal que Amazon tuvo que dejar de usar porque calificaba negativamente los perfiles de mujeres. ¿Qué pasó? El sistema fue entrenado a partir de los perfiles de todos los empleados que ya habían sido contratados: la mayoría hombres. Es así que el algoritmo «heredó» los sesgos machistas de las prácticas de la compañía. También podemos ver los sesgos en la mega industria de los robots sexuales, dirigidas a hombres y que reproducen cuerpos hegemónicos, frente al sector de los muñecos bebés reborn, dirigida a mujeres, de tendencia artesanal.

Desarrollando asistentes feministas

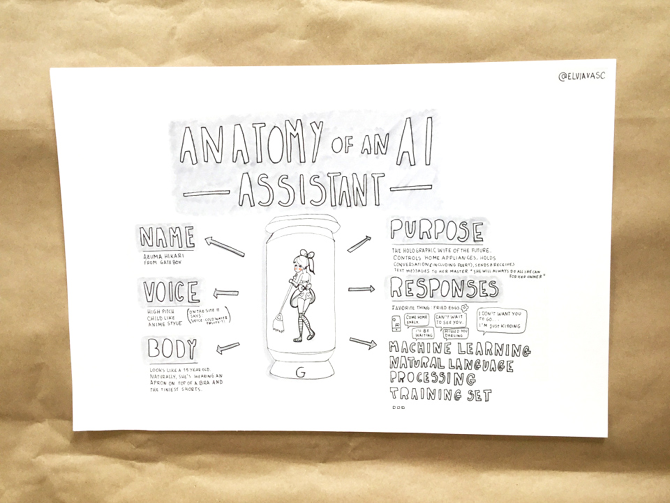

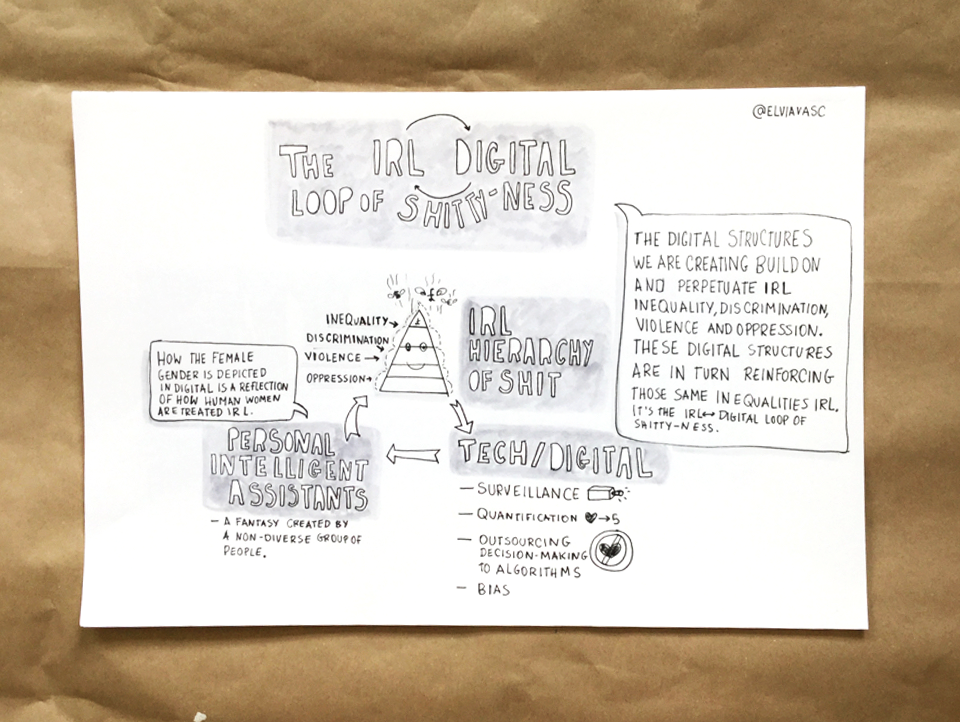

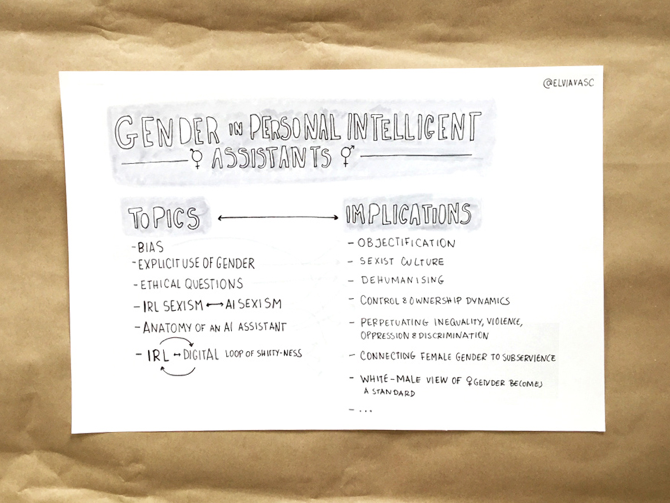

Entonces, ¿qué otra cosa podemos hacer para eliminar este sesgo?. Elvia Vasconcelos, una diseñadora e investigadora portuguesa se pregunta si pueden existir asistentes personales feministas y explora las posibilidades con una serie de proyectos. Por un lado, lleva adelante un Diario de Alexa, que documenta las interacciones entre un humano y un asistente personal virtual de Amazon. Por el otro, lleva adelante un taller de ficción especulativa para explorar las maneras en las que género y tecnología se relacionan a partir de los sesgos de nuestras sociedades. El taller consiste en tres etapas:

1. Entender que el uso del género en la inteligencia artificial no es neutral. Se identifican los estereotipos y las maneras en las que las mujeres fueron representadas en la ciencia ficción y cómo son representandas ahora en los asistentes personales virtuales. ¿Qué vínculos podemos establecer?

2. Discutir y entender como la inteligencia artificial no es más que un reflejo de los valores de la sociedad que la desarrolla. Tal es así que «perpetúa la desigualdad, discriminación, violencia y opresión de la vida real».

3. Las participantes hacen un ejercicio de ficción especulativa para contar historias del futuro sobre la tecnología de las asistentes personales que pongan en cuestión los sesgos machistas.

¿Qué otros ejemplos de sesgo de género encuentras en los algoritmos que usas cotidianamente? ¿Y sesgos racistas o colonialistas? ¿Qué ideas se te ocurren para eliminarlos?